150.47MBZIP

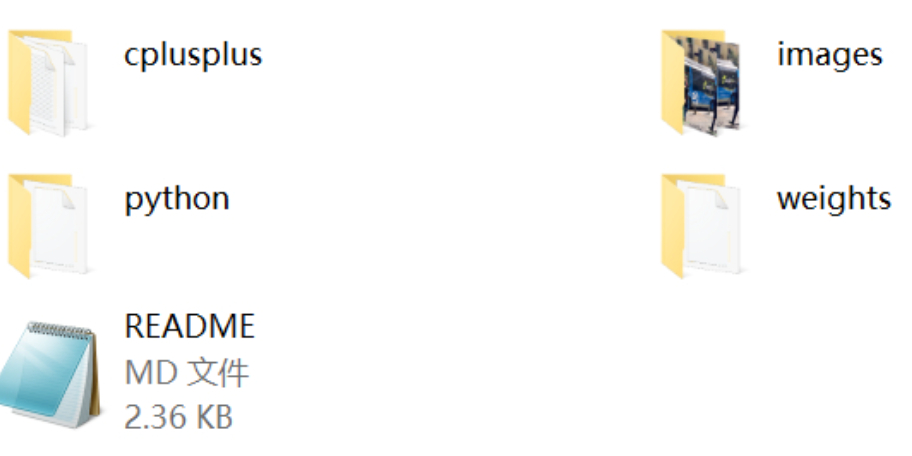

在这个项目中,我们将深入探讨如何使用C++和Python结合ONNXRuntime来部署RT-DETR目标检测算法。RT-DETR(Real-Time DETR)是一种高效的目标检测模型,它基于DETR(DEtection TRansformer),但进行了优化以提高推理速度。DETR是Facebook AI Research提出的一种端到端的检测器,它利用Transformer架构处理图像识别任务,消除了传统对象检测器中的锚框和非最大抑制步骤。

让我们详细了解RT-DETR。DETR引入了Transformer的自注意力机制,这使得模型能够处理全局上下文信息,从而更准确地识别和定位目标。然而,原始DETR的推理速度较慢,因为它需要进行大量的计算。RT-DETR通过引入一系列优化技术,如更小的输入分辨率、轻量级的Transformer编码器和更快的解码器,显著提高了模型的运行速度,使其更适合实时应用。

接下来,我们来看看ONNXRuntime。ONNXRuntime是一个跨平台的高性能推理引擎,支持多种框架(如TensorFlow、PyTorch)导出的ONNX模型。ONNX(Open Neural Network Exchange)是一种开放标准,用于表示机器学习模型,使得不同框架之间的模型转换和运行变得可能。使用ONNXRuntime部署RT-DETR可以实现跨平台的高效推理,同时利用其优化功能来进一步提升性能。

在C++和Python中部署RT-DETR,你需要完成以下步骤:

1. **模型转换**:将训练好的PyTorch RT-DETR模型转换为ONNX格式。这通常涉及到使用`torch.onnx.export`函数,确保模型处于评估模式,并设置合适的输入形状。

2. **验证模型**:转换后,使用ONNX的验证工具检查模型是否正确无误,确保所有操作符都得到了ONNXRuntime的支持。

3. **编译ONNX模型**:使用ONNXRuntime的API加载ONNX模型,并进行编译。这一步会根据目标硬件环境生成最佳的执行计划。

4. **编写推理代码**:在C++或Python中编写推理代码,加载编译后的执行计划,预处理输入图像,然后调用ONNXRuntime的`Run`方法进行预测。

5. **后处理结果**:由于目标检测模型通常输出边界框坐标和类别概率,你需要进行后处理,如NMS(非极大值抑制)以去除重复的检测结果。

6. **优化性能**:你可以使用ONNXRuntime提供的选项进行性能优化,如多线程执行、内存优化等。

项目源码中应包含这些步骤的详细实现,包括预处理、模型加载、推理和后处理的代码示例。通过对源码的分析和实践,你可以更好地理解如何在实际项目中部署RT-DETR模型,以及如何利用ONNXRuntime和C++/Python来提高效率。

这个项目提供了一个宝贵的实战机会,让你了解如何将先进的目标检测算法RT-DETR与高效的推理引擎ONNXRuntime相结合,实现C++和Python的跨平台部署。通过这个过程,你不仅能够增强对DETR和Transformer的理解,还能深入掌握ONNX和ONNXRuntime的使用技巧,提升你的算法部署能力。

资源声明(购买视为同意此声明): 1.在网站平台的任何操作视为已阅读和同意网站底部的注册协议及免责声明,本站资源已是超低价,且不提供技术支持 2.部分网络用户分享网盘地址有可能会失效,如发生失效情况请发邮件给客服code711cn#qq.com (把#换成@)会进行补发 3.本站站内提供的所有可下载资源(软件等等)本站保证未做任何负面改动;但本网站不能保证资源的准确性、安全性和完整性,用户下载后自行斟酌,我们以交流学习为目的,并不是所有的源码都不是100%无错或无bug;需要您有一定的基础能够看懂代码,能够自行调试修改代码并解决报错。同时本站用户必须明白,源码便利店对提供下载的软件等不拥有任何权利,其版权归该资源的合法拥有者所有。 4.本站所有资源仅用于学习及研究使用,请必须在24小时内删除所下载资源,切勿用于商业用途,否则由此引发的法律纠纷及连带责任本站和发布者概不承担 5.因资源可复制性,一旦购买均不退款,充值余额也不退款